近日,我院于国际学习表征会议(International Conference on Learning Representations,ICLR 2021)发表一项重要研究成果:

Towards Robustness Against Natural Language Word Substitutions

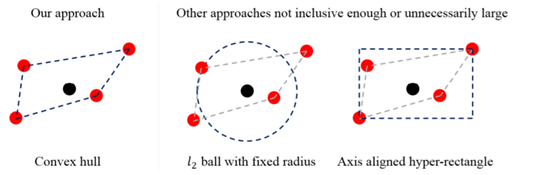

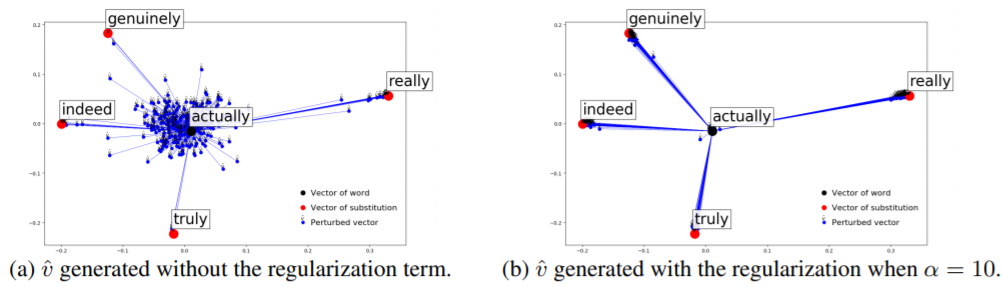

本文由新加坡南洋理工大学董新帅同学、日本国立信息学研究所刘弘博士、厦门大学纪荣嵘教授、以及麻省理工学院的Anh Tuan Luu博士合作完成。论文中的董新帅同学和刘弘博士皆为厦门大学MAC实验室毕业学生,通讯作者是纪荣嵘教授。该论文提出一种面向词替换攻击的对抗训练方法。该方法先将词替换攻击建模为词向量空间上的凸包络,并香农熵对凸组合参数进行正则,提出了对抗稀疏凸组合模型,该模型可以贴合语言的规律,高效地生成对抗句子,以攻击已有深度语言模型。随后,将该模型与对抗训练整合实现不易被攻击的鲁棒模型训练。相比之前的方法,该模型有如下的好处:1)包含所有可能出现的对抗噪声。2)凸集利于优化 3)替换词组集合的数量最小。论文提出的防御方法在情感分类和语言推断任务中均有较大的鲁棒性提升

ICLR是图灵奖获得者、深度学习三巨头之二的 Yoshua Bengio 和 Yann LeCun于2013年创办。ICLR 2021论文投稿数量继续增长,共获得 2997 篇有效投稿,860 篇论文最终被接收,其中 53 篇将进行口头讲述报告,114 篇 Spotlight论文,其余为 Poster 论文。该会议目前的谷歌学术h5指数已经排到了全榜第 17 名,已超过了众多CCF-A类会议,如NeurIPS、ICCV、ICML等。